Sprawdź plik robots.txt

Twój plik robots.txt mówi robotom indeksującym, czy wolno im indeksować Twoją stronę, czy nie.

Podczas tworzenia strony internetowej, zazwyczaj wyłącza się wszelkie opcje indeksowania witryny, aby Google (i inne wyszukiwarki) nie indeksowały jej zanim będzie ona gotowa.

W WordPressie najczęściej robi się to z panelu administracyjnego WordPress, w zakładce „Ustawienia” – „Czytanie” – „Widoczność dla wyszukiwarek” – „Proś wyszukiwarki o nieindeksowanie tej witryny”.

Oczywiście trzeba to wyłączyć, gdy nadejdzie czas oficjalnego uruchomienia witryny, a przetestowanie zawartości pliku robot.txt powie Ci, czy nadal blokujesz roboty indeksujące wyszukiwarek, czy nie.

Jak sprawdzić plik robots.txt

Najprostszym sposobem na sprawdzenie pliku robots.txt jest wpisanie domeny głównej w pasku adresu, a następnie '/robots.txt’, zaraz po nazwie domeny (np. https://estartupy.pl/robots.txt). Oto jak wygląda przykładowy plik robots.txt:

Jak edytować plik robots.txt?

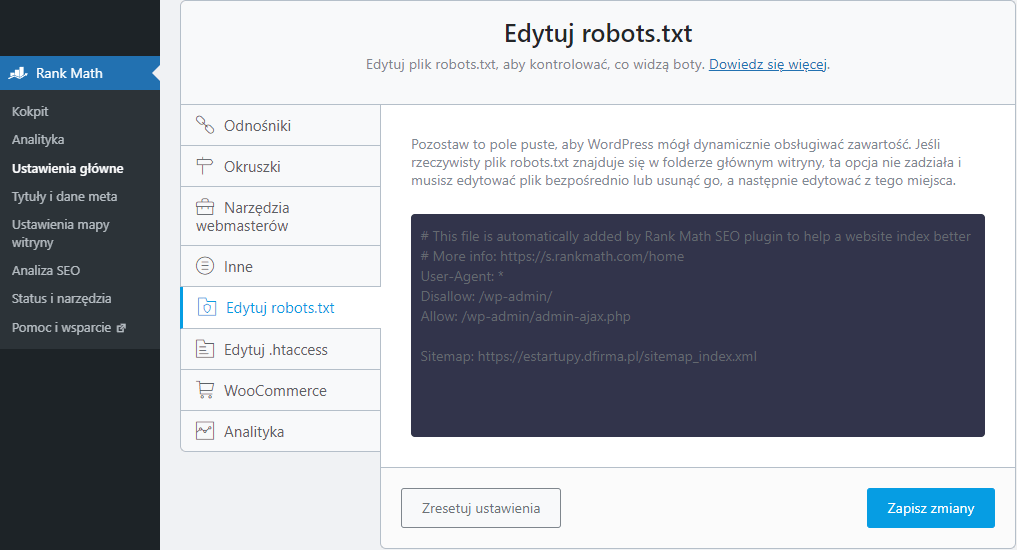

Istnieje kilka sposobów na edycję pliku robots.txt, ale najprostszym jest chyba wykorzystanie do tego wtyczki SEO.

Większość wtyczek SEO (darmowych i płatnych) pozwala na edycję pliku robots.txt w prosty sposób, bezpośrednio z panelu administracyjnego WordPress. Jeśli nie możesz znaleźć tej funkcji w swojej wtyczce SEO, spróbuj przeszukać dokumentację.

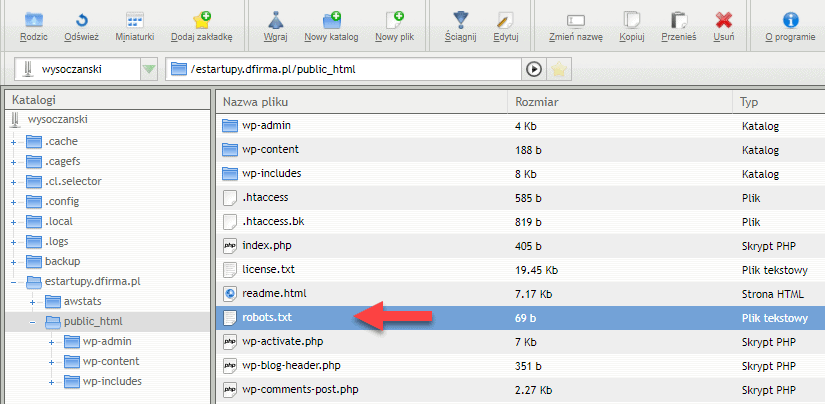

Inną opcją jest edycja pliku robots.txt bezpośrednio na serwerze za pomocą menedżera plików hostingu, lub przez FTP.

Jeśli wiesz jak połączyć się ze swoim serwerem poprzez FTP, to możesz edytować plik ręcznie w zwykłym edytorze tekstowym.

Gdzie jest plik robots.txt zlokalizowany?

Plik robots.txt znajduje się w katalogu głównym Twojej domeny. Po zalogowaniu się na serwer poprzez FTP, pliku robots.txt należy szukać w katalogu public_html (jeżeli go tam nie ma, należy go utworzyć).

Jak powinien wyglądać plik robots.txt

Treść pliku robots.txt ostatecznie zależy od tego, co chcesz mieć zindeksowane na swojej stronie, a co nie.

Oto krótkie wyjaśnienie, jak działa plik robots.txt (na przykładzie poniżej).

Linia „User-agent:” w przykładzie zawiera gwiazdkę (*), co oznacza, że zasady poniżej tej linii mają zastosowanie do wszystkich robotów indeksujących.

Linia „Disallow:” (uniemożliwiaj) mówi agentowi (w naszym przypadku wszystkim robotom indeksującym), aby nie odwiedzał katalogu „/wp-admin/” (wraz z wszystkimi jego podkatalogami), czyli żeby nie przeszukiwał zaplecza twojej strony.

Linia „Allow:” (umożliwiaj) w przykładzie poniżej robi jeden wyjątek dla konkretnego adresu URL po „/wp-admin/”, który jedną linię wyżej zabroniliśmy odwiedzać.

Niektóre wtyczki lub funkcje Twojej strony internetowej mogą dodać więcej linii kodu niż to, co widać w przykładowej treści pliku robots.txt poniżej. Treść pliku robots.txt podana poniżej, to standardowa zawartość tego pliku dla WordPressa:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Jeśli chcesz ograniczyć indeksowanie niektórych stron, możesz umieścić ich adresy URL w pliku robots.txt po linii „Disallow:”. Jednak najczęściej robi się to za pomocą wtyczki SEO, nadając konkretnej stronie tag „noindex”.